สารบัญ:

- ขั้นตอนที่ 1: ภาพรวมของโครงการ

- ขั้นตอนที่ 2: การวิจัยเบื้องหลัง

- ขั้นตอนที่ 3: ข้อกำหนดการออกแบบ

- ขั้นตอนที่ 4: การออกแบบทางวิศวกรรมและการเลือกอุปกรณ์

- ขั้นตอนที่ 5: การเลือกอุปกรณ์: วิธีการโต้ตอบ

- ขั้นตอนที่ 6: การเลือกอุปกรณ์: ไมโครคอนโทรลเลอร์

- ขั้นตอนที่ 7: การเลือกอุปกรณ์: เซ็นเซอร์

- ขั้นตอนที่ 8: การเลือกอุปกรณ์: ซอฟต์แวร์

- ขั้นตอนที่ 9: การเลือกอุปกรณ์: ส่วนอื่นๆ

- ขั้นตอนที่ 10: การพัฒนาระบบ: การสร้างฮาร์ดแวร์ ตอนที่ 1

- ขั้นตอนที่ 11: การพัฒนาระบบ: การสร้างฮาร์ดแวร์ ตอนที่ 2

- ขั้นตอนที่ 12: การพัฒนาระบบ: การเขียนโปรแกรมระบบ ตอนที่ 1

- ผู้เขียน John Day day@howwhatproduce.com.

- Public 2024-01-30 13:05.

- แก้ไขล่าสุด 2025-01-23 15:12.

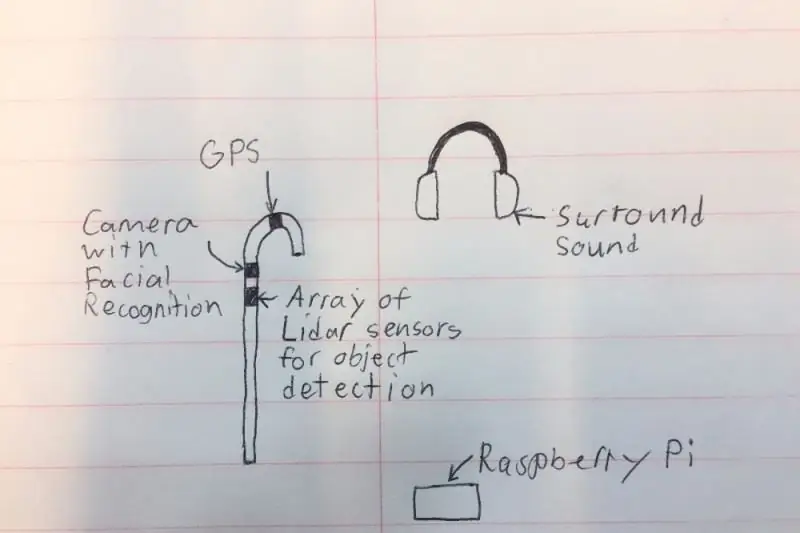

ฉันต้องการสร้าง 'อ้อย' อัจฉริยะที่สามารถช่วยเหลือผู้ที่มีความบกพร่องทางสายตาได้มากกว่าโซลูชันที่มีอยู่ ไม้เท้าจะแจ้งเตือนผู้ใช้วัตถุที่อยู่ด้านหน้าหรือด้านข้างโดยส่งเสียงในหูฟังชนิดเสียงรอบทิศทาง ไม้เท้ายังมีกล้องขนาดเล็กและ LIDAR (Light Detection and Ranging) เพื่อให้สามารถจดจำวัตถุและผู้คนในห้องและแจ้งให้ผู้ใช้ทราบโดยใช้หูฟัง ด้วยเหตุผลด้านความปลอดภัย หูฟังจะไม่ปิดกั้นเสียงรบกวนทั้งหมด เนื่องจากจะมีไมโครโฟนที่สามารถกรองเสียงที่ไม่จำเป็นทั้งหมด และรักษาเสียงแตรรถและผู้คนพูดคุย สุดท้ายระบบจะมี GPS เพื่อให้สามารถบอกเส้นทางและแสดงให้ผู้ใช้ทราบว่าจะไปที่ใด

โปรดลงคะแนนให้ฉันในการแข่งขันไมโครคอนโทรลเลอร์และฟิตเนสกลางแจ้ง!

ขั้นตอนที่ 1: ภาพรวมของโครงการ

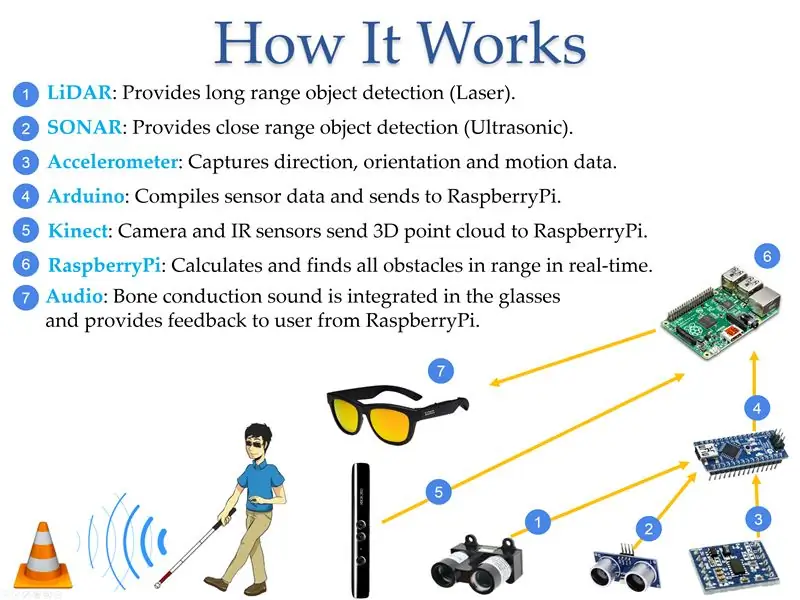

ตาม World Access for the Blind การเคลื่อนไหวทางกายภาพเป็นหนึ่งในความท้าทายที่ยิ่งใหญ่ที่สุดสำหรับคนตาบอด การเดินทางหรือเพียงแค่เดินไปตามถนนที่พลุกพล่านอาจเป็นเรื่องยากมาก ตามเนื้อผ้า ทางออกเดียวคือการใช้ "ไม้เท้าขาว" ที่รู้จักกันทั่วไป ซึ่งส่วนใหญ่ใช้เพื่อสแกนสภาพแวดล้อมโดยรอบโดยการชนสิ่งกีดขวางที่อยู่ใกล้เคียงของผู้ใช้ ทางออกที่ดีกว่าคืออุปกรณ์ที่สามารถแทนที่ผู้ช่วยที่มองเห็นได้โดยการให้ข้อมูลเกี่ยวกับตำแหน่งของสิ่งกีดขวางเพื่อให้คนตาบอดสามารถออกไปในสภาพแวดล้อมที่ไม่รู้จักและรู้สึกปลอดภัย ในระหว่างโครงการนี้ ได้มีการพัฒนาอุปกรณ์ที่ใช้แบตเตอรี่ขนาดเล็กที่ตรงตามเกณฑ์เหล่านี้ อุปกรณ์สามารถตรวจจับขนาดและตำแหน่งของวัตถุโดยใช้เซ็นเซอร์ที่วัดตำแหน่งของวัตถุที่สัมพันธ์กับผู้ใช้ ถ่ายทอดข้อมูลนั้นไปยังไมโครคอนโทรลเลอร์ แล้วแปลงเป็นเสียงเพื่อให้ข้อมูลแก่ผู้ใช้ อุปกรณ์นี้สร้างขึ้นโดยใช้ LIDAR เชิงพาณิชย์ (Light Detection and Ranging), SONAR (Sound Navigation and Ranging) และเทคโนโลยีคอมพิวเตอร์วิทัศน์ที่เชื่อมโยงกับไมโครคอนโทรลเลอร์ และตั้งโปรแกรมเพื่อให้เอาต์พุตข้อมูลเสียงที่จำเป็นโดยใช้หูฟังเอียร์บัดหรือหูฟัง เทคโนโลยีการตรวจจับถูกฝังอยู่ภายใน "ไม้เท้าขาว" เพื่อระบุสภาพของผู้ใช้และให้ความปลอดภัยเพิ่มเติมแก่ผู้อื่น

ขั้นตอนที่ 2: การวิจัยเบื้องหลัง

ในปี 2560 องค์การอนามัยโลกรายงานว่ามีผู้พิการทางสายตา 285 ล้านคนทั่วโลก โดย 39 ล้านคนตาบอดสนิท คนส่วนใหญ่ไม่ได้คิดถึงปัญหาที่ผู้พิการทางสายตาเผชิญอยู่ทุกวัน ตาม World Access for the Blind การเคลื่อนไหวทางกายภาพเป็นหนึ่งในความท้าทายที่ยิ่งใหญ่ที่สุดสำหรับคนตาบอด การเดินทางหรือเพียงแค่เดินไปตามถนนที่พลุกพล่านอาจเป็นเรื่องยากมาก ด้วยเหตุนี้ ผู้คนจำนวนมากที่มีความบกพร่องทางการมองเห็นจึงชอบพาเพื่อนหรือสมาชิกในครอบครัวที่มีสายตาสั้นมาช่วยนำทางในสภาพแวดล้อมใหม่ๆ ตามเนื้อผ้า วิธีแก้ปัญหาเดียวคือการใช้ "ไม้เท้าขาว" ที่รู้จักกันทั่วไป ซึ่งส่วนใหญ่ใช้เพื่อสแกนสภาพแวดล้อมโดยรอบโดยการชนสิ่งกีดขวางที่อยู่ใกล้เคียงของผู้ใช้ ทางออกที่ดีกว่าคืออุปกรณ์ที่สามารถแทนที่ผู้ช่วยที่มองเห็นได้โดยการให้ข้อมูลเกี่ยวกับตำแหน่งของสิ่งกีดขวางเพื่อให้คนตาบอดสามารถออกไปในสภาพแวดล้อมที่ไม่รู้จักและรู้สึกปลอดภัย NavCog ซึ่งเป็นความร่วมมือระหว่าง IBM และ Carnegie Mellon University ได้พยายามแก้ปัญหาด้วยการสร้างระบบที่ใช้บลูทูธบีคอนและสมาร์ทโฟนเพื่อช่วยแนะนำ อย่างไรก็ตาม การแก้ปัญหานั้นยุ่งยากและพิสูจน์แล้วว่ามีค่าใช้จ่ายสูงสำหรับการใช้งานขนาดใหญ่ โซลูชันของฉันแก้ไขปัญหานี้โดยขจัดความต้องการอุปกรณ์ภายนอกและโดยใช้เสียงเพื่อแนะนำผู้ใช้ตลอดทั้งวัน (รูปที่ 3) ข้อดีของการมีเทคโนโลยีฝังอยู่ใน "ไม้เท้าขาว" คือการส่งสัญญาณให้โลกที่เหลือถึงสภาพของผู้ใช้ซึ่งทำให้เกิดการเปลี่ยนแปลงในพฤติกรรมของคนรอบข้าง

ขั้นตอนที่ 3: ข้อกำหนดการออกแบบ

หลังจากค้นคว้าเทคโนโลยีที่มีอยู่ ฉันได้หารือเกี่ยวกับวิธีแก้ปัญหาที่เป็นไปได้กับผู้เชี่ยวชาญด้านการมองเห็นเกี่ยวกับแนวทางที่ดีที่สุดในการช่วยให้ผู้ที่มีความบกพร่องทางสายตาสำรวจสภาพแวดล้อมของตนได้ดีที่สุด ตารางด้านล่างแสดงคุณลักษณะที่สำคัญที่สุดที่จำเป็นสำหรับผู้อื่นในการเปลี่ยนไปใช้อุปกรณ์ของฉัน

คุณลักษณะ - คำอธิบาย:

- การคำนวณ - ระบบจำเป็นต้องจัดเตรียมการประมวลผลที่รวดเร็วสำหรับข้อมูลที่แลกเปลี่ยนระหว่างผู้ใช้และเซ็นเซอร์ ตัวอย่างเช่น ระบบจะต้องสามารถแจ้งให้ผู้ใช้ทราบถึงสิ่งกีดขวางที่อยู่ข้างหน้าซึ่งอยู่ห่างออกไปอย่างน้อย 2 เมตร

- ความครอบคลุม - ระบบจำเป็นต้องให้บริการทั้งภายในและภายนอกอาคารเพื่อปรับปรุงคุณภาพชีวิตของผู้พิการทางสายตา

- เวลา - ระบบควรทำงานได้ดีในเวลากลางวันและกลางคืน

- พิสัย - พิสัยคือระยะห่างระหว่างผู้ใช้กับวัตถุที่ระบบจะตรวจจับ ช่วงต่ำสุดในอุดมคติคือ 0.5 ม. ในขณะที่ช่วงสูงสุดควรมากกว่า 5 ม. ระยะทางไกลจะดียิ่งขึ้นไปอีกแต่มีความท้าทายในการคำนวณมากกว่า

- ประเภทอ็อบเจ็กต์ - ระบบควรตรวจจับการปรากฏของอ็อบเจ็กต์อย่างกะทันหัน ระบบควรจะสามารถบอกความแตกต่างระหว่างวัตถุที่เคลื่อนที่และวัตถุคงที่ได้

ขั้นตอนที่ 4: การออกแบบทางวิศวกรรมและการเลือกอุปกรณ์

หลังจากดูส่วนประกอบต่างๆ มากมายแล้ว ฉันตัดสินใจเลือกชิ้นส่วนจากหมวดหมู่ต่างๆ ด้านล่าง

ราคาของชิ้นส่วนที่เลือก:

- Zungle Panther: 149.99 เหรียญสหรัฐ

- LiDAR Lite V3: $149.99

- LV-MaxSonar-EZ1: $29.95

- อัลตราโซนิกเซนเซอร์ - HC-SR04: $3.95

- Raspberry Pi 3: $39.95

- Arduino: $24.95

- Kinect: $32.44

- Floureon 11.1v 3s 1500mAh: $19.99

- LM2596HV: $9.64

ขั้นตอนที่ 5: การเลือกอุปกรณ์: วิธีการโต้ตอบ

ฉันตัดสินใจใช้การควบคุมด้วยเสียงเป็นวิธีการโต้ตอบกับอุปกรณ์ เนื่องจากการมีปุ่มหลายปุ่มบนไม้เท้าอาจเป็นเรื่องยากสำหรับผู้พิการทางสายตา โดยเฉพาะอย่างยิ่งหากฟังก์ชันบางอย่างต้องใช้ปุ่มผสมกัน ด้วยการควบคุมด้วยเสียง ผู้ใช้สามารถใช้คำสั่งที่กำหนดไว้ล่วงหน้าเพื่อสื่อสารกับไม้เท้าซึ่งช่วยลดข้อผิดพลาดที่อาจเกิดขึ้น

อุปกรณ์: ข้อดี --- จุดด้อย:

- ปุ่ม: ไม่มีข้อผิดพลาดของคำสั่งเมื่อกดปุ่มขวา --- อาจเป็นการท้าทายเพื่อให้แน่ใจว่ากดปุ่มที่ถูกต้อง

- การควบคุมด้วยเสียง: ง่ายเพราะผู้ใช้สามารถใช้คำสั่งที่ตั้งไว้ --- การออกเสียงที่ไม่ถูกต้องอาจทำให้เกิดข้อผิดพลาด

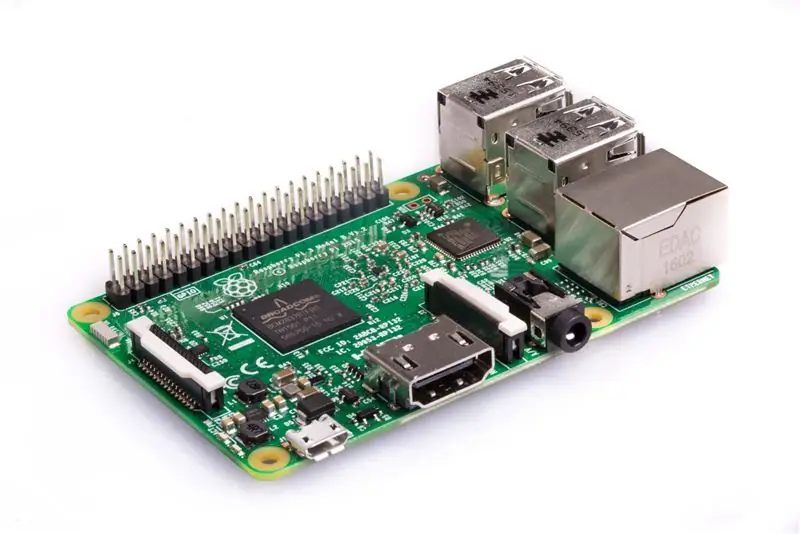

ขั้นตอนที่ 6: การเลือกอุปกรณ์: ไมโครคอนโทรลเลอร์

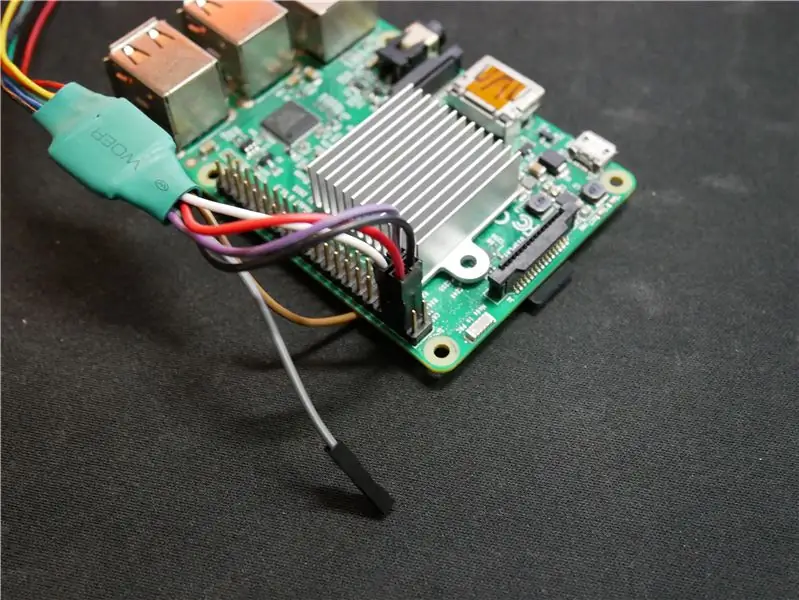

อุปกรณ์ใช้ Raspberry Pi เนื่องจากมีต้นทุนต่ำและกำลังประมวลผลเพียงพอที่จะคำนวณแผนที่ความลึก Intel Joule จะเป็นตัวเลือกที่ต้องการ แต่ราคาจะเพิ่มเป็นสองเท่าของระบบซึ่งจะไม่เหมาะกับอุปกรณ์นี้ซึ่งได้รับการพัฒนาเพื่อให้ตัวเลือกต้นทุนที่ต่ำกว่าสำหรับผู้ใช้ Arduino ถูกนำมาใช้ในระบบเพราะสามารถรับข้อมูลจากเซ็นเซอร์ได้อย่างง่ายดาย ไม่ได้ใช้ BeagleBone และ Intel Edison เนื่องจากอัตราส่วนราคาต่อประสิทธิภาพต่ำ ซึ่งไม่ดีสำหรับระบบต้นทุนต่ำนี้

ไมโครคอนโทรลเลอร์: ข้อดี --- จุดด้อย:

- Raspberry Pi: มีพลังในการประมวลผลเพียงพอสำหรับการค้นหาสิ่งกีดขวาง และมี WiFi/Bluetooth ในตัว --- มีตัวเลือกไม่มากนักในการรับข้อมูลจากเซ็นเซอร์

- Arduino: รับข้อมูลจากเซ็นเซอร์ขนาดเล็กได้อย่างง่ายดาย เช่น. LIDAR, Ultrasonic, SONAR ฯลฯ --- พลังการประมวลผลไม่เพียงพอสำหรับการค้นหาสิ่งกีดขวาง

- Intel Edison: สามารถประมวลผลสิ่งกีดขวางได้อย่างรวดเร็วด้วยโปรเซสเซอร์ที่รวดเร็ว --- ต้องใช้ชิ้นส่วนของนักพัฒนาเพิ่มเติมในการทำงานสำหรับระบบ

- Intel Joule: มีความเร็วในการประมวลผลเป็นสองเท่าของไมโครคอนโทรลเลอร์ในตลาดผู้บริโภคจนถึงปัจจุบัน --- ค่าใช้จ่ายสูงมากสำหรับระบบนี้และยากที่จะโต้ตอบกับ GPIO สำหรับการโต้ตอบกับเซ็นเซอร์

- BeagleBone Black: กะทัดรัดและเข้ากันได้กับเซ็นเซอร์ที่ใช้ในโครงการโดยใช้ General Purpose Input Output (GPIO) --- พลังการประมวลผลไม่เพียงพอในการค้นหาวัตถุอย่างมีประสิทธิภาพ

ขั้นตอนที่ 7: การเลือกอุปกรณ์: เซ็นเซอร์

ใช้เซ็นเซอร์หลายตัวร่วมกันเพื่อให้ได้ตำแหน่งที่แม่นยำสูง Kinect เป็นเซ็นเซอร์หลักเนื่องจากพื้นที่ที่สามารถสแกนหาสิ่งกีดขวางได้ในคราวเดียว LIDAR ซึ่งย่อมาจาก LIight Detection and Ranging เป็นวิธีการตรวจจับระยะไกลที่ใช้แสงในรูปแบบของเลเซอร์พัลซิ่งเพื่อวัดระยะทางจากตำแหน่งที่เซ็นเซอร์ไปยังวัตถุอย่างรวดเร็ว เซ็นเซอร์นั้นใช้เพราะสามารถติดตามพื้นที่ได้ไกลถึง 40 เมตร (m) และเนื่องจากสามารถสแกนในมุมต่างๆ ได้ จึงสามารถตรวจจับได้ว่ามีขั้นตอนใดขึ้นหรือลงหรือไม่ การนำทางและการวัดเสียง (SONAR) และเซ็นเซอร์อัลตราโซนิกใช้เป็นการติดตามสำรองในกรณีที่ Kinect พลาดเสาหรือกระแทกบนพื้นที่อาจก่อให้เกิดอันตรายต่อผู้ใช้ 9 Degrees of Freedom Sensor ใช้สำหรับติดตามทิศทางที่ผู้ใช้หันหน้าไปเพื่อให้อุปกรณ์สามารถจัดเก็บข้อมูลเพื่อความแม่นยำที่สูงขึ้นในการนำทางในครั้งต่อไปที่บุคคลนั้นเดินไปที่เดิม

เซนเซอร์: ข้อดี --- จุดด้อย:

- Kinect V1: สามารถติดตามวัตถุ 3 มิติด้วย --- กล้องเพียงตัวเดียวในการตรวจจับสภาพแวดล้อม

- Kinect V2: มีกล้องอินฟราเรด 3 ตัว และกล้องสีแดง เขียว น้ำเงิน ลึก (RGB-D) สำหรับการตรวจจับวัตถุ 3 มิติที่มีความแม่นยำสูง --- สามารถทำความร้อนและอาจต้องใช้พัดลมระบายความร้อน และมีขนาดใหญ่กว่าเซ็นเซอร์อื่นๆ

- LIDAR: ลำแสงที่สามารถติดตามตำแหน่งได้ไกลถึง 40 เมตร --- จำเป็นต้องจัดตำแหน่งให้เข้าหาวัตถุและมองไปในทิศทางนั้นเท่านั้น

- SONAR: ลำแสงที่สามารถติดตามได้ไกล 5 เมตร แต่อยู่ในระยะไกล --- วัตถุขนาดเล็กเช่นขนนกสามารถกระตุ้นเซ็นเซอร์ได้

- Ultrasonic: มีพิสัยถึง 3 ม. และมีราคาไม่แพงมาก --- ระยะทางอาจคลาดเคลื่อนในบางครั้ง

- 9 Degrees of Freedom Sensor: ดีสำหรับการตรวจจับการวางแนวและความเร็วของผู้ใช้ --- หากมีสิ่งใดรบกวนเซนเซอร์ การคำนวณระยะทางสามารถคำนวณได้ไม่ถูกต้อง

ขั้นตอนที่ 8: การเลือกอุปกรณ์: ซอฟต์แวร์

ซอฟต์แวร์ที่เลือกสำหรับต้นแบบสองสามตัวแรกที่สร้างด้วยเซ็นเซอร์ Kinect V1 คือ Freenect แต่ก็ไม่แม่นยำมาก เมื่อเปลี่ยนไปใช้ Kinect V2 และ Freenect2 ผลการติดตามได้รับการปรับปรุงอย่างมีนัยสำคัญเนื่องจากการติดตามที่ดีขึ้นเนื่องจาก V2 มีกล้อง HD และกล้องอินฟราเรด 3 ตัว ซึ่งต่างจากกล้องตัวเดียวใน Kinect V1 เมื่อฉันใช้ OpenNi2 กับ Kinect V1 ฟังก์ชันมีจำกัด และฉันไม่สามารถควบคุมฟังก์ชันบางอย่างของอุปกรณ์ได้

ซอฟต์แวร์: ข้อดี --- จุดด้อย:

- Freenect: มีระดับการควบคุมที่ต่ำกว่าสำหรับการควบคุมทุกอย่าง --- รองรับ Kinect V1. เท่านั้น

- OpenNi2: สามารถสร้างข้อมูล point cloud จากสตรีมข้อมูลจาก Kinect ได้อย่างง่ายดาย --- รองรับเฉพาะ Kinect V1 และไม่รองรับการควบคุมระดับต่ำ

- Freenect2: มีระดับการควบคุมที่ต่ำกว่าสำหรับแถบเซ็นเซอร์ --- ใช้ได้กับ Kinect V2. เท่านั้น

- ROS: ระบบปฏิบัติการที่เหมาะสำหรับการตั้งโปรแกรมฟังก์ชั่นกล้อง --- จำเป็นต้องติดตั้งบนการ์ด SD ที่รวดเร็วเพื่อให้ซอฟต์แวร์ทำงานได้

ขั้นตอนที่ 9: การเลือกอุปกรณ์: ส่วนอื่นๆ

แบตเตอรี่ลิเธียมไอออนได้รับการคัดเลือกเนื่องจากมีน้ำหนักเบา มีความจุสูง และชาร์จไฟได้ แบตเตอรี่ลิเธียมไอออนรุ่น 18650 ที่มีรูปทรงทรงกระบอกและเข้ากับต้นแบบอ้อยได้พอดี อ้อยต้นแบบที่ 1 ทำจากท่อพีวีซี เนื่องจากเป็นโพรงและช่วยลดน้ำหนักของอ้อย

ขั้นตอนที่ 10: การพัฒนาระบบ: การสร้างฮาร์ดแวร์ ตอนที่ 1

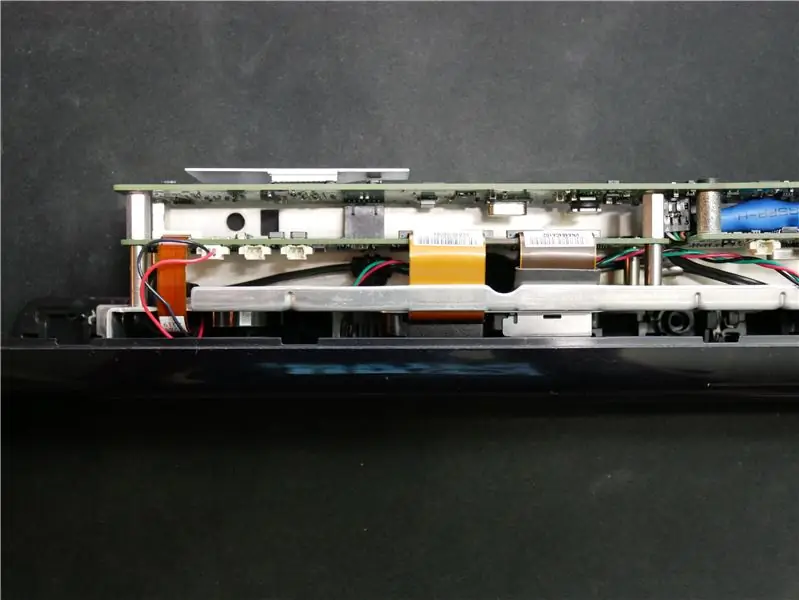

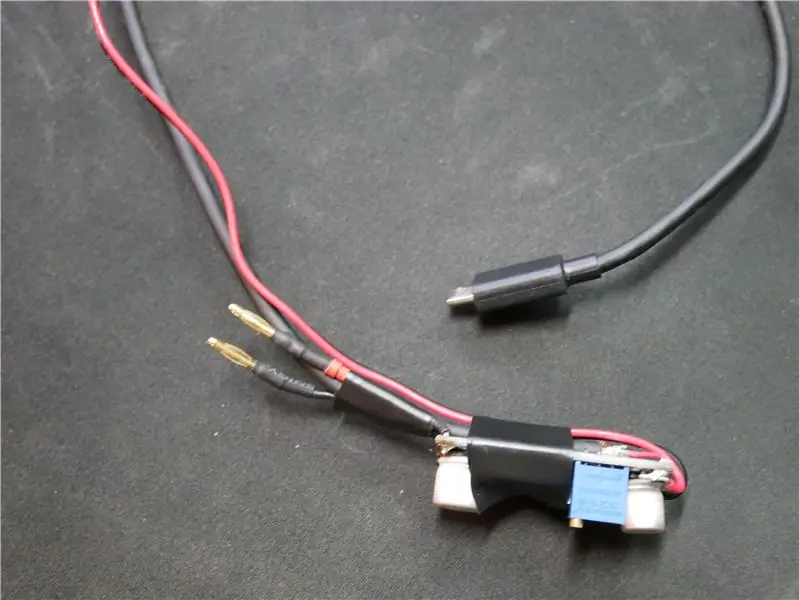

อันดับแรก เราต้องถอด Kinect ออกเพื่อให้มีน้ำหนักเบาลง และเพื่อให้พอดีกับไม้เท้า ฉันเริ่มต้นด้วยการนำปลอกด้านนอกทั้งหมดออกจาก Kinect เนื่องจากพลาสติกที่ใช้มีน้ำหนักมาก จากนั้นฉันต้องตัดสายเคเบิลเพื่อให้สามารถถอดฐานออกได้ ฉันนำสายไฟจากขั้วต่อที่แสดงในภาพแล้วบัดกรีเข้ากับสาย usb ที่มีสายสัญญาณ และอีกสองจุดเชื่อมต่อสำหรับกำลังอินพุต 12V เนื่องจากฉันต้องการให้พัดลมในอ้อยทำงานเต็มกำลังเพื่อทำให้ส่วนประกอบอื่นๆ เย็นลง ฉันจึงตัดตัวเชื่อมต่อออกจากพัดลมจาก Kinect และต่อสาย 5V จาก Raspberry Pi ฉันยังสร้างอะแดปเตอร์ขนาดเล็กสำหรับสาย LiDAR เพื่อให้สามารถเชื่อมต่อโดยตรงกับ Raspberry Pi โดยไม่ต้องใช้ระบบอื่นใดในระหว่างนั้น

ฉันบัดกรีลวดสีขาวไปเป็นสีดำโดยไม่ได้ตั้งใจ ดังนั้นอย่าดูภาพสำหรับไดอะแกรมการเดินสาย

ขั้นตอนที่ 11: การพัฒนาระบบ: การสร้างฮาร์ดแวร์ ตอนที่ 2

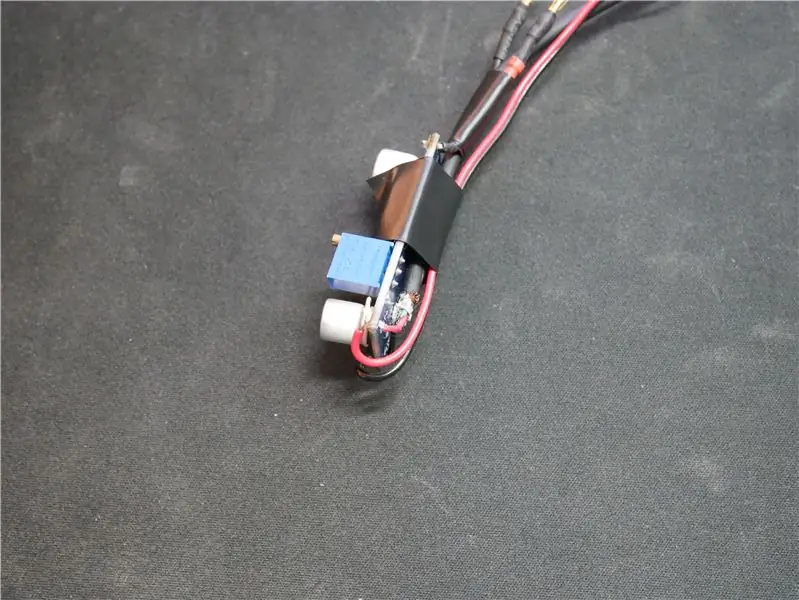

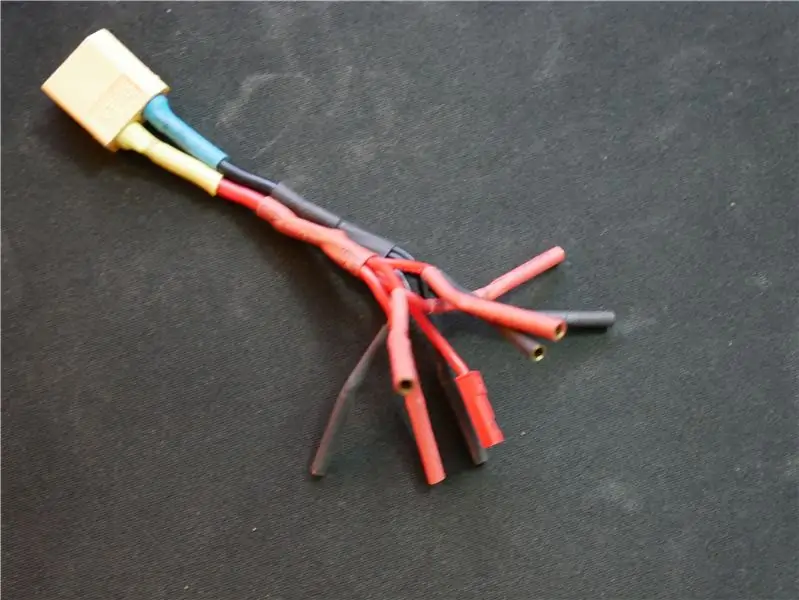

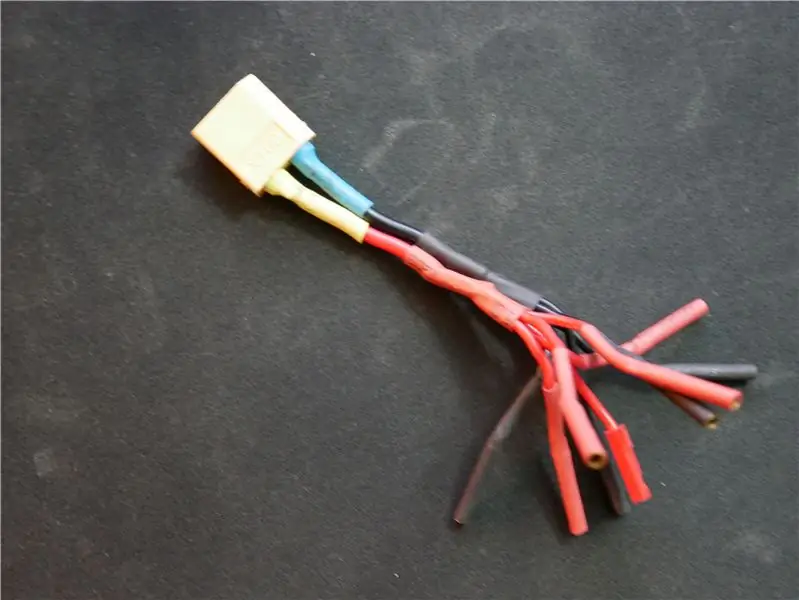

ฉันสร้างส่วนควบคุมเพื่อให้พลังงานแก่อุปกรณ์ทั้งหมดที่ต้องการ 5V เช่น Raspberry Pi ฉันปรับเรกูเลเตอร์โดยวางมิเตอร์ไว้ที่เอาต์พุตและปรับตัวต้านทานเพื่อให้เรกูเลเตอร์จ่าย 5.05V ฉันตั้งให้สูงกว่า 5V เล็กน้อยเพราะเมื่อเวลาผ่านไป แรงดันแบตเตอรี่จะลดลงและส่งผลต่อแรงดันไฟขาออกเล็กน้อย ฉันยังสร้างอะแดปเตอร์ที่ช่วยให้ฉันสามารถจ่ายไฟให้กับอุปกรณ์ 5 เครื่องที่ต้องใช้ไฟ 12V จากแบตเตอรี่

ขั้นตอนที่ 12: การพัฒนาระบบ: การเขียนโปรแกรมระบบ ตอนที่ 1

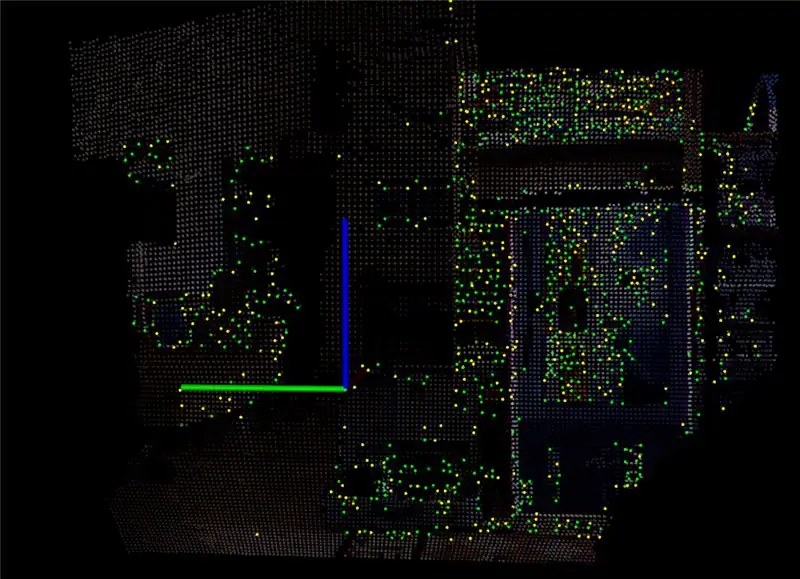

หนึ่งในส่วนที่ท้าทายที่สุดของระบบนี้คือการเขียนโปรแกรม เมื่อฉันได้ให้ Kinect เล่นเป็นครั้งแรก ฉันได้ติดตั้งโปรแกรมชื่อ RTAB Map ซึ่งใช้สตรีมข้อมูลจาก Kinect และแปลงเป็น point cloud ด้วย point cloud มันสร้างภาพ 3 มิติที่สามารถหมุนได้ เพื่อดูความลึกของตำแหน่งของวัตถุทั้งหมด หลังจากลองเล่นสักพักและปรับการตั้งค่าทั้งหมดแล้ว ฉันตัดสินใจติดตั้งซอฟต์แวร์บางตัวบน Raspberry Pi เพื่อให้ฉันเห็นสตรีมข้อมูลจาก Kinect สองภาพสุดท้ายด้านบนแสดงให้เห็นว่า Raspberry Pi สามารถผลิตอะไรได้บ้างที่ประมาณ 15-20 เฟรมต่อวินาที

แนะนำ:

[2020] การใช้ IPhone หรือ IPad และ Micro:bit Game Pad App เพื่อควบคุมรถ RC: 23 ขั้นตอน

![[2020] การใช้ IPhone หรือ IPad และ Micro:bit Game Pad App เพื่อควบคุมรถ RC: 23 ขั้นตอน [2020] การใช้ IPhone หรือ IPad และ Micro:bit Game Pad App เพื่อควบคุมรถ RC: 23 ขั้นตอน](https://i.howwhatproduce.com/images/001/image-1423-j.webp)

[2020] การใช้ IPhone หรือ IPad และแอพเกมแพด Micro:bit เพื่อควบคุมรถ RC: คุณเคยคิดหรือไม่ว่าจะใช้ iPhone หรือ iPad เพื่อควบคุม micro:bit ของคุณ คุณรู้หรือไม่ว่า Micro:bit Educational Foundation มีแอพ iOS ใน แอพสโตร์? ค้นหา "micro:bit" ใน App Store และคุณสามารถดาวน์โหลดแอปได้ฟรี NS

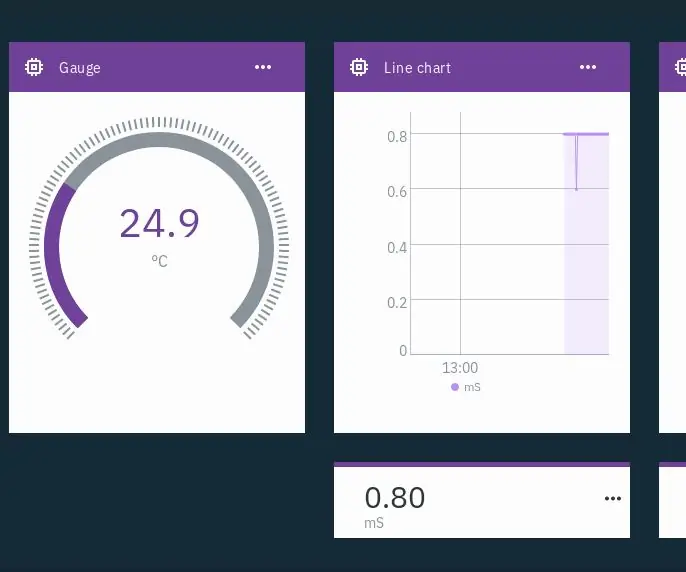

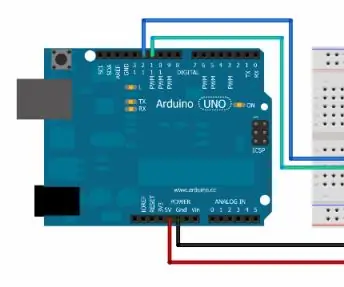

IoT Hydroponics - การใช้ Watson ของ IBM สำหรับการวัดค่า PH และ EC: 7 ขั้นตอน (พร้อมรูปภาพ)

IoT Hydroponics - การใช้ Watson ของ IBM สำหรับการวัด PH และ EC: คำแนะนำนี้จะแสดงวิธีการตรวจสอบ EC, pH และอุณหภูมิของการตั้งค่าไฮโดรโปนิกส์และอัปโหลดข้อมูลไปยังบริการ Watson ของ IBM วัตสันมีอิสระที่จะเริ่มต้น มีแผนชำระเงิน แต่แผนฟรีมีมากเกินพอสำหรับโครงการนี้

การใช้ PCF8574 Backpacks พร้อม LCD และ Arduino: 8 ขั้นตอน

การใช้ PCF8574 Backpacks พร้อม LCD และ Arduino: การใช้โมดูล LCD กับ Arduino ของคุณเป็นที่นิยม อย่างไรก็ตาม จำนวนการเดินสายต้องใช้เวลาและความอดทนในการต่อสายอย่างถูกต้อง และยังใช้พินเอาต์พุตดิจิทัลจำนวนมาก นั่นเป็นเหตุผลที่เราชื่นชอบโมดูลแบ็คแพ็คแบบอนุกรมเหล่านี้ - ติดตั้งเข้ากับเ

การใช้ Ultrasonic Distance Sensor และ Serial Monitor Output: 6 ขั้นตอน

การใช้ Ultrasonic Distance Sensor และ Serial Monitor Output: เฮ้พวก! ต้องการเรียนรู้วิธีใช้เอาต์พุตมอนิเตอร์แบบอนุกรม ที่นี่คุณมีบทช่วยสอนที่สมบูรณ์แบบเกี่ยวกับวิธีการทำเช่นนั้น! ในคำแนะนำนี้ ฉันจะแนะนำคุณตลอดขั้นตอนง่าย ๆ ที่จำเป็นในการตรวจจับระยะทางโดยใช้เซ็นเซอร์อัลตราโซนิกและรายงานฉัน

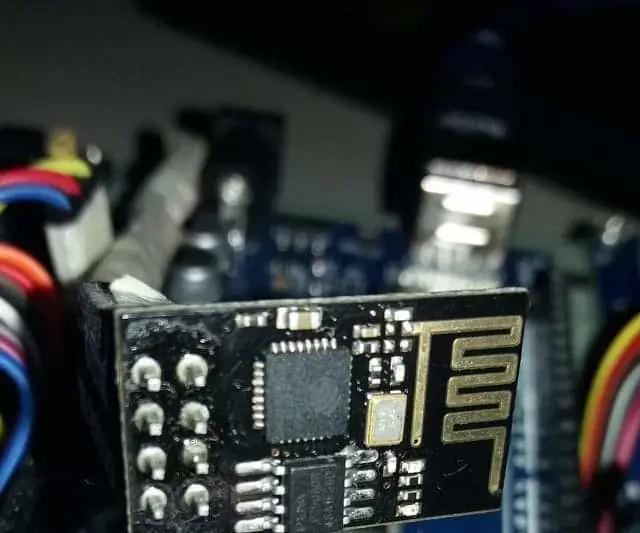

การใช้ ESP8266 กับ Arduino และ Blynk: 4 ขั้นตอน

การใช้ ESP8266 กับ Arduino และ Blynk: เชื่อมต่อ Arduino Mega ของคุณกับแอป blynk โดยใช้ espp8266 shield