สารบัญ:

- ผู้เขียน John Day day@howwhatproduce.com.

- Public 2024-01-30 13:07.

- แก้ไขล่าสุด 2025-01-23 15:12.

สวัสดีทุกคน, ในคำแนะนำนี้ ฉันจะแสดงให้คุณเห็นถึงความคืบหน้าสำหรับโครงการติดตามวัตถุของฉัน ที่นี่คุณสามารถค้นหาคำแนะนำก่อนหน้า: https://www.instructables.com/id/Object-Tracking/ และที่นี่คุณจะพบเพลย์ลิสต์ youtube พร้อมทั้งหมด คำอธิบายวิดีโอและโค้ด:

ในที่สุด เราก็สามารถย้ายจากโลกของซอฟต์แวร์และการเขียนโค้ดล้วนๆ ไปสู่โลกที่แท้จริงได้ โดยวางกล้องไว้บนแท่นยึดและเคลื่อนย้ายแท่นยึดเพื่อติดตามวัตถุ มาดูกันว่าทำอย่างไร!

ขั้นตอนที่ 1: ติดตั้งกล้อง:

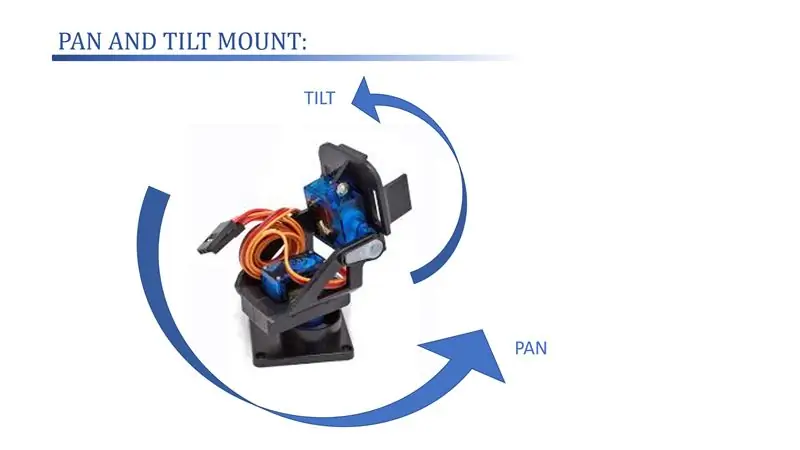

นี่คือแท่นยึดกล้องที่เราจะใช้ มันเข้ากันไม่ได้กับเว็บแคมอย่างสมบูรณ์และวิธีที่ฉันยึดกล้องเข้ากับเมาท์นั้นเป็นพื้นฐานเล็กน้อยที่จะพูดอย่างน้อย:D

แต่มันจะทำในตอนนี้และในอนาคต ฉันอาจจะพิมพ์ 3 มิติของอะแดปเตอร์บางประเภทหรือสร้างมันขึ้นมาใหม่ทั้งหมด

เมาท์ประเภทนี้มักเรียกกันว่า "แพนและฐานเอียง" เนื่องจากมีมอเตอร์ 2 ตัวสำหรับควบคุมกระทะ (การหมุนบนระนาบแนวนอน) และการเอียง (การหมุนรอบแกน y หรือ "ขึ้น-ลง") ดังแสดงใน ภาพ.

ขั้นตอนที่ 2: Arduino และ RC-Servo Motors:

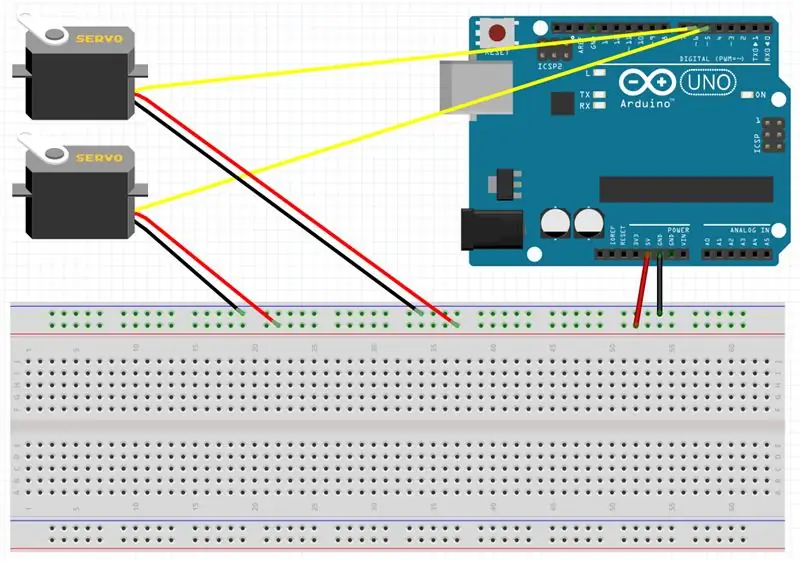

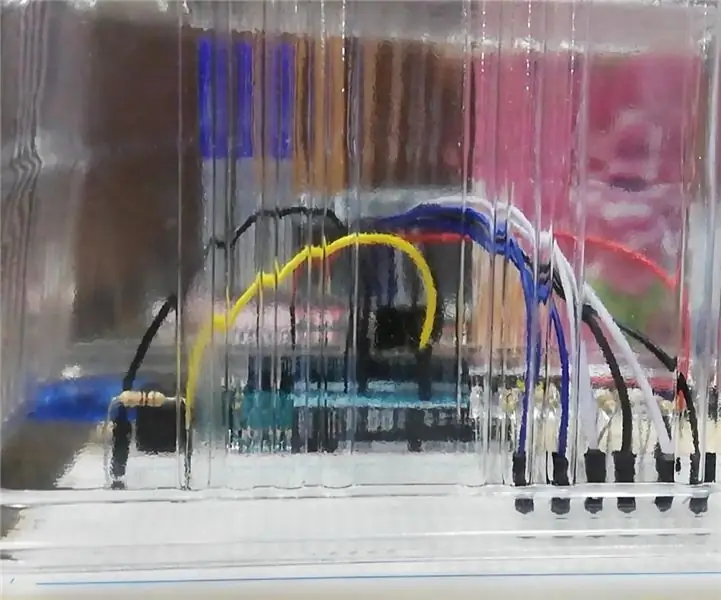

ในการควบคุมเมาท์เราจะใช้มอเตอร์ RC-Servo 2 ตัวและ Arduino Uno

ในภาพคุณสามารถเห็นการเชื่อมต่อที่จำเป็น:

เอียงเซอร์โว: กราวด์ - กราวด์เขียงหั่นขนม

VCC -- เขียงหั่นขนมVCC

สัญญาณ -- พิน D6

แพนเซอร์โว: กราวด์ - กราวด์เขียงหั่นขนม

VCC -- เขียงหั่นขนมVCC

สัญญาณ -- พิน D5

ขั้นตอนที่ 3: รหัส Matlab:

Arduino จะถูกควบคุมทั้งหมดด้วย Matlab โดยใช้กล่องเครื่องมือ Arduino จาก Matlab

ในส่วนนี้คุณจะพบรหัส:

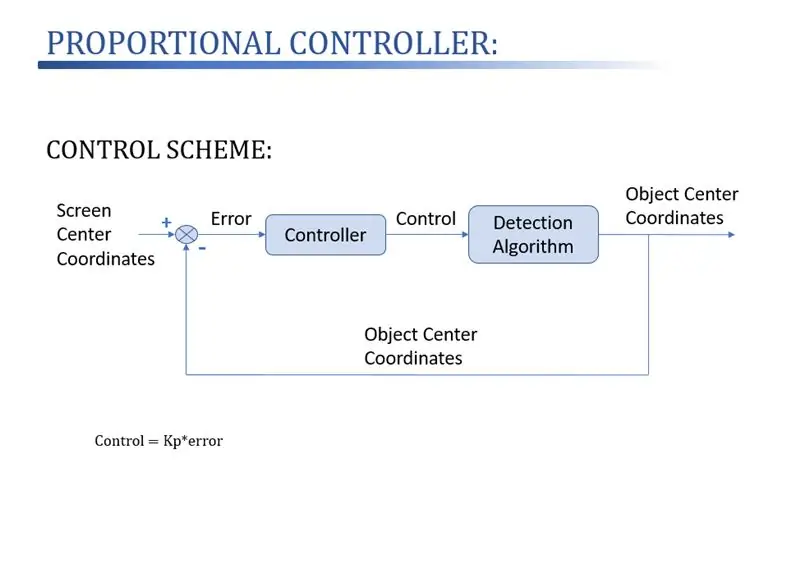

blueCircleFollow2.m เป็นฟังก์ชัน "หลัก" K_proportional1.m เป็นสคริปต์เสริมที่เรียกจากสคริปต์อื่น โดยพื้นฐานแล้วจะมีตัวควบคุมตามสัดส่วน

วิธีควบคุมที่ใช้แสดงอยู่ในภาพ: ตำแหน่งอ้างอิงที่เราต้องการให้วงกลมวัตถุอยู่ที่ศูนย์กลางของหน้าจอ ตัวควบคุมตามสัดส่วนจะทำหน้าที่ควบคุมสัญญาณเซอร์โวเพื่อรับข้อผิดพลาด ซึ่งกำหนดไว้เป็นจุดศูนย์กลางของภาพ - วงกลม ศูนย์ ถึง 0

ขั้นตอนที่ 4: การแสดง:

คุณจะพบวิดีโอสองรายการที่แสดงวิธีการทำงานของอัลกอริธึมและคอนโทรลเลอร์ได้ที่นี่

ในวิดีโอแรก ที่ยาวกว่านั้น มีการอธิบายโค้ด โครงสร้าง และกลยุทธ์การควบคุมอย่างลึกซึ้งยิ่งขึ้น วิดีโอที่สองเป็นวิดีโอที่แยกจากวิดีโอแรกที่มีเฉพาะวิดีโอของระบบที่ติดตามวัตถุ

อย่างที่คุณเห็นว่าอัลกอริธึมมีความสามารถมากกว่าที่จะติดตามวัตถุเมื่อเคลื่อนที่ไปรอบๆ แต่ฉันเชื่อว่ายังมีที่ว่างสำหรับการปรับปรุง โดยแนะนำตัวควบคุมที่ซับซ้อนมากกว่าแค่สัดส่วน (coff PID coff coff) และแนวคิดอื่นๆ อีกสองสามข้อ

หากคุณมีคำถามใด ๆ อย่าลังเลที่จะถามพวกเขาในความคิดเห็น และหากคุณต้องการดูขั้นตอนต่อไป สมัครรับข้อมูลช่อง YouTube ของฉัน ฉันจะใส่ทุกอย่างไว้ที่นั่น!

แนะนำ:

การออกแบบเกมในการสะบัดใน 5 ขั้นตอน: 5 ขั้นตอน

การออกแบบเกมในการสะบัดใน 5 ขั้นตอน: การตวัดเป็นวิธีง่ายๆ ในการสร้างเกม โดยเฉพาะอย่างยิ่งเกมปริศนา นิยายภาพ หรือเกมผจญภัย

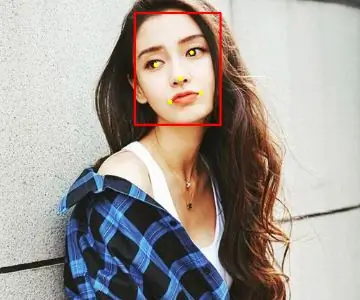

การตรวจจับใบหน้าบน Raspberry Pi 4B ใน 3 ขั้นตอน: 3 ขั้นตอน

การตรวจจับใบหน้าบน Raspberry Pi 4B ใน 3 ขั้นตอน: ในคำแนะนำนี้ เราจะทำการตรวจจับใบหน้าบน Raspberry Pi 4 ด้วย Shunya O/S โดยใช้ Shunyaface Library Shunyaface เป็นห้องสมุดจดจำใบหน้า/ตรวจจับใบหน้า โปรเจ็กต์นี้มีจุดมุ่งหมายเพื่อให้เกิดความเร็วในการตรวจจับและจดจำได้เร็วที่สุดด้วย

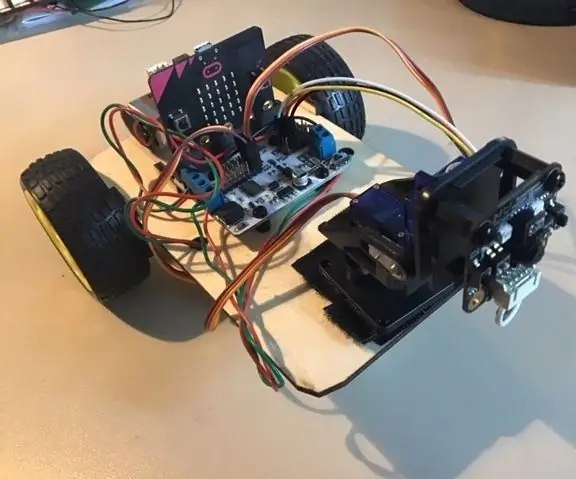

Micro:bit MU Vision Sensor - การติดตามวัตถุ: 7 ขั้นตอน

Micro:bit MU Vision Sensor - การติดตามวัตถุ: ดังนั้นในคำแนะนำนี้เราจะเริ่มเขียนโปรแกรม Smart Car ที่เราสร้างในคำแนะนำนี้และเราติดตั้งเซ็นเซอร์วิชันซิสเต็ม MU ในคำแนะนำนี้ เราจะตั้งโปรแกรมไมโคร: บิตด้วยการติดตามวัตถุง่ายๆ ดังนั้น th

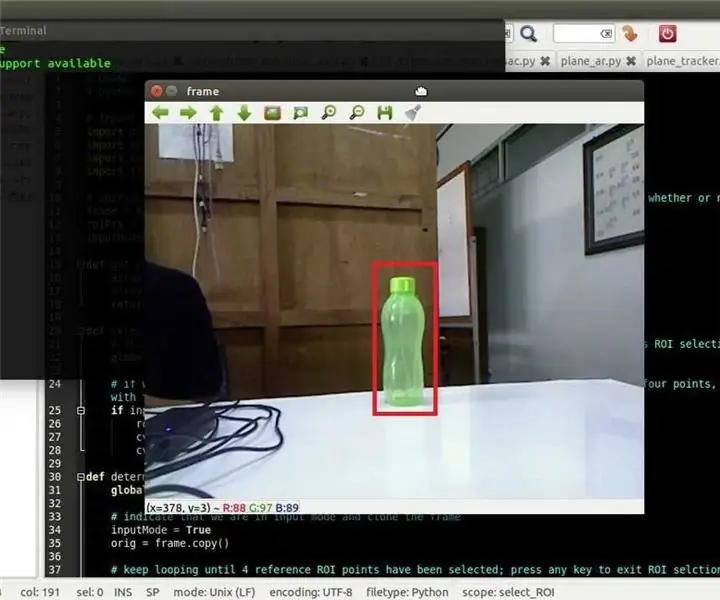

การติดตามวัตถุ Opencv: 3 ขั้นตอน

การติดตามวัตถุ Opencv: การตรวจจับวัตถุเคลื่อนที่เป็นเทคนิคที่ใช้ในการมองเห็นด้วยคอมพิวเตอร์และการประมวลผลภาพ เฟรมที่ต่อเนื่องกันหลายเฟรมจากวิดีโอจะถูกเปรียบเทียบโดยวิธีต่างๆ เพื่อระบุว่ามีการตรวจพบวัตถุที่เคลื่อนที่หรือไม่ การตรวจจับวัตถุเคลื่อนที่ถูกใช้สำหรับ

Micro:bit MU Vision Sensor - การติดตามวัตถุ: 6 ขั้นตอน

Micro:bit MU Vision Sensor - การติดตามวัตถุ: นี่เป็นแนวทางที่สี่ของฉันเกี่ยวกับเซ็นเซอร์วิชัน MU สำหรับ micro:bit ฉันจะอธิบายวิธีการติดตามวัตถุด้วย micro:bit และเขียนพิกัดไปยังหน้าจอ OLED ฉันมีคำแนะนำอื่นๆ เกี่ยวกับวิธีการเชื่อมต่อ micro:bit กับ